Protocole de Contexte du Modèle (PCM) : Le Guide d'Adoption

Protocole de Contexte du Modèle (PCM) : Le Guide d'Adoption

Notion

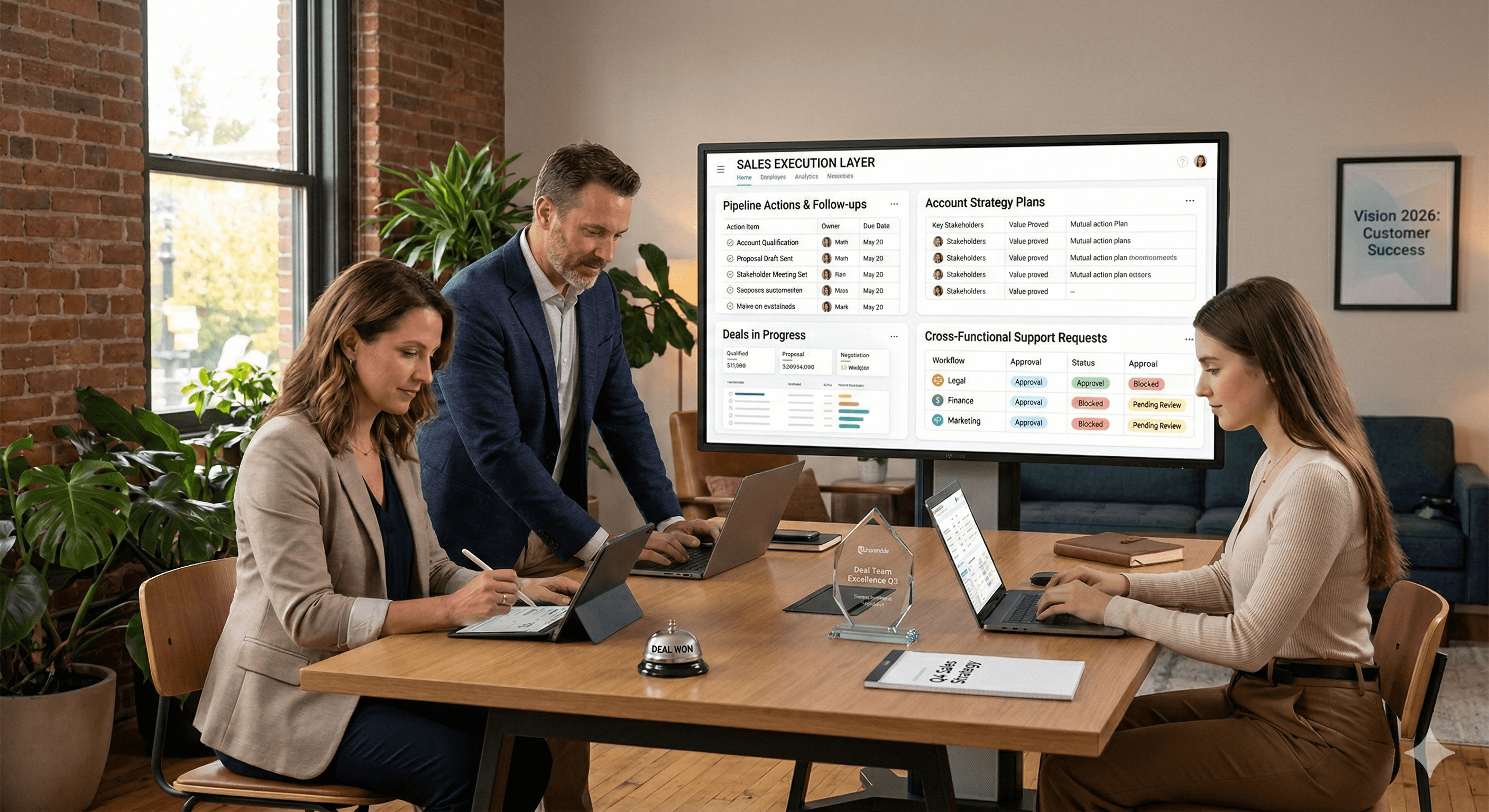

Exploiter

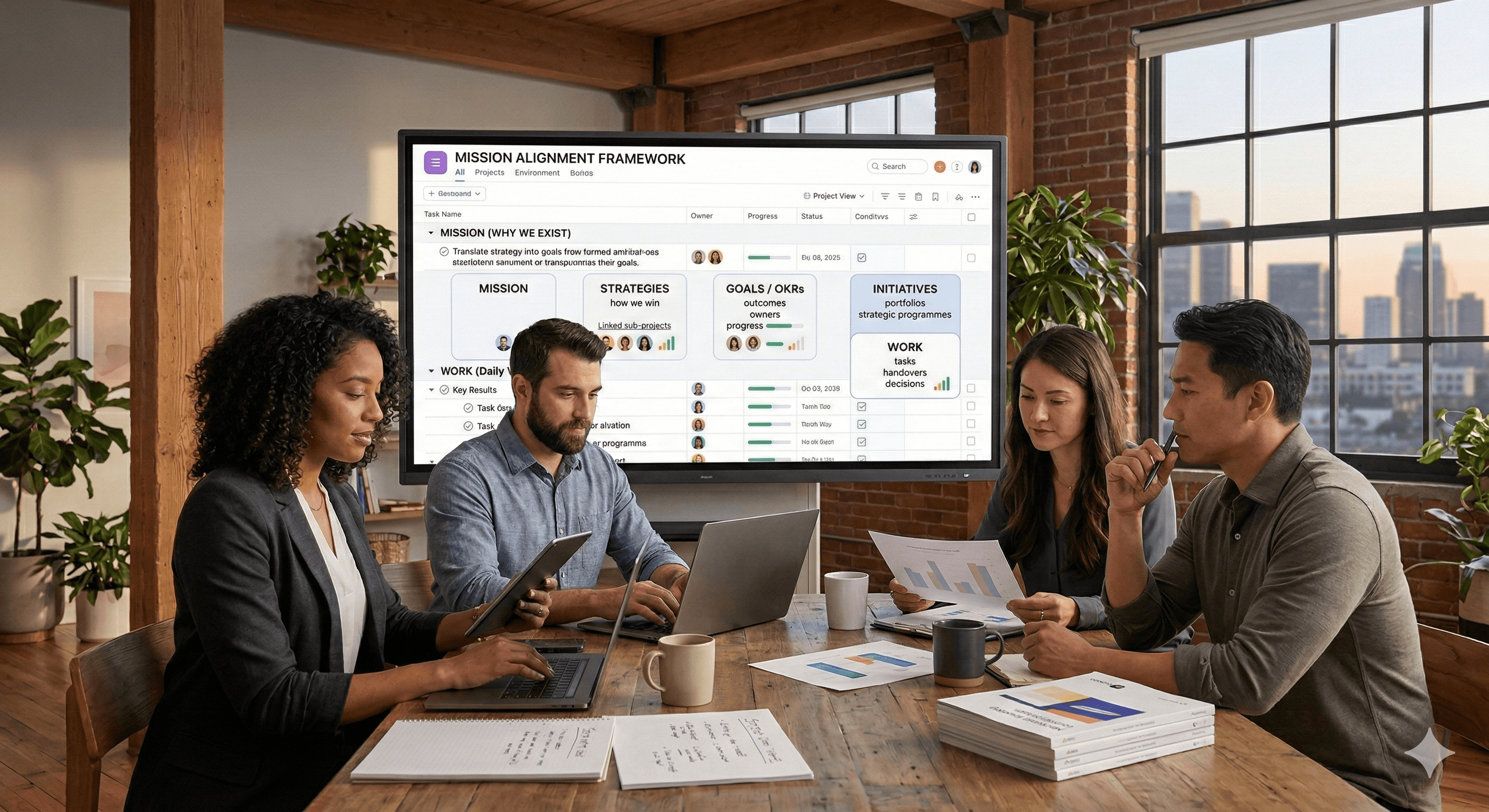

Asana

Miro

20 nov. 2025

Pas sûr de quoi faire ensuite avec l'IA?

Évaluez la préparation, les risques et les priorités en moins d'une heure.

Pas sûr de quoi faire ensuite avec l'IA?

Évaluez la préparation, les risques et les priorités en moins d'une heure.

➔ Téléchargez notre kit de préparation à l'IA gratuit

Protocole de Contexte Modèle (PCM) : Ce que c'est et comment l'adopter

Si votre feuille de route inclut des assistants IA qui agissent sur des systèmes réels, en créant des tickets, en publiant sur Slack, en interrogeant Snowflake, le PCM est la manière la plus rapide et la moins risquée pour mettre cela en place. Né à la fin de 2024 et renforcé tout au long de 2025, le PCM standardise la manière dont les applications de LLM se connectent aux outils et aux données, vous évitant ainsi de reconstruire les intégrations pour chaque modèle ou fournisseur.

Définition en 60 secondes

Le PCM est un protocole ouvert pour connecter les applications IA (le “hôte”) à des capacités externes via un modèle client-serveur. L'hôte intègre un client PCM ; vos outils/données résident derrière un ou plusieurs serveurs PCM. Le client parle un protocole bien spécifié (JSON-RPC 2.0) permettant au LLM de découvrir des outils, appeler des fonctions, et récupérer un contexte de manière cohérente.

Pensez au PCM comme à l'USB-C pour l'IA, un port qui fonctionne avec de nombreux périphériques. Remplacez Claude par ChatGPT ou vice-versa sans réécrire chaque connecteur.

Pourquoi le PCM est important pour les équipes SaaS en 2025

Réduit le problème N×M. Au lieu de construire N intégrations sur mesure pour M modèles, le PCM abstrait l'interface de sorte qu'un serveur peut fonctionner avec plusieurs hôtes LLM. Cela réduit la complexité et le délai de mise sur le marché.

Momentum écosystémique large. Le PCM a commencé avec Anthropic et apparaît maintenant dans les environnements de développement intégrés (IDE), Claude Desktop, et les connecteurs/SDK d'agents d'OpenAI—avec un support précoce dans le mode développeur de ChatGPT. Cette énergie inter-fournisseurs est pourquoi de nombreux CIO considèrent le PCM comme le chemin par défaut vers le SaaS « prêt pour les agents ».

Des modèles de qualité entreprise émergent. Les fournisseurs publient des couches de sécurité « défendre pour PCM » et des modèles centrés sur le chiffrement alignés sur les secteurs réglementés, accélérant l'adoption sécurisée.

Architecture de base (modèle mental simple)

Hôte : L'application IA (par exemple, Claude Desktop, ChatGPT) exécutant un client PCM.

Client PCM : Traduit l'intention de l'utilisateur/appels outil en messages de protocole.

Serveur(s) PCM : Votre côté — APIs, bases de données, ou flux de travail exposés avec des définitions d'outils basées sur un schéma et des réponses via JSON-RPC 2.0.

Cette séparation permet aux équipes de la plateforme de publier un catalogue de capacités sécurisées (par exemple, « créer un problème Jira », « interroger BigQuery ») que tout LLM conforme peut utiliser—sous réserve de politique et d'autorisation.

Quelles plateformes supportent actuellement le PCM ?

Anthropic Claude / Claude Desktop : Référence PCM de première partie avec de nombreux exemples de serveurs. anthropic.com

OpenAI : Connecteurs et serveurs PCM distants via l'API/SDK d'agents d'OpenAI ; un support client plus large est en émergence dans le mode développeur. OpenAI Platform

Outils développeur : Serveurs officiels et communautaires pour GitHub, Buildkite et plus ; des listes open-source florissantes pour accélérer l'intégration. GitHub

Intérêt industriel : Microsoft a publiquement soutenu les standards industriels comme le PCM pour aider les écosystèmes d'agents à interagir.

Notre écosystème partenaire (prêt pour le PCM)

Asana — Serveur PCM officiel permet aux outils IA de créer/lire des tâches et d'interagir avec le Work Graph via des outils standards. (Asana)

Miro — Serveur PCM disponible (actuellement étiqueté bêta/liste d'attente dans certains matériaux) pour interroger le contexte du tableau et déclencher des actions à partir des outils IA. (developers.miro.com)

Notion — Le Notion PCM hébergé permet une lecture/écriture sécurisée des objets de l'espace de travail ; fonctionne avec Claude, ChatGPT et Cursor. (developers.notion.com)

Glean — Serveur PCM distant intégré à la plateforme pour exposer la connaissance d'entreprise sensible aux permissions à tout hôte compatible PCM. (developers.glean.com)

Partenaire | Statut PCM | Docs |

|---|---|---|

Asana | GA : serveur PCM officiel | Documents « Serveur PCM » et guide d'intégration. Asana |

Miro | Bêta / liste d'attente notée dans le site | Guides développeur + page publique de liste d'attente. developers.miro.com |

Notion | GA : PCM hébergé | Documents développeur + aperçu du centre d'aide. developers.notion.com |

Glean | GA : serveur PCM distant | Guides administrateur et utilisateur. developers.glean.com |

Sécurité : ce que le PCM résout—et ce qu'il ne résout pas

Le PCM n'est pas une solution miracle. Il vous offre un conduit cohérent ; vous avez toujours besoin de garde-fous d'entreprise :

Menaces : Injection de demande, serveurs surprivileges, et sorties non fiables peuvent entraîner des fuites de données ou des actions involontaires (par ex., « PCM-MAJ »).

Contrôles à ajouter :

Forte authentification/autorisation à la frontière du serveur (tokens, mTLS, RBAC limité).

Filtres de politique pour restreindre les arguments et les sorties des outils.

Audit/enregistrement de chaque appel et réponse d'outil.

Modèles de sécurité des données (chiffrement au niveau de l'application / gardez vos propres clés) pour les stocks sensibles.

Construire vs acheter : serveurs PCM

Vous pouvez construire des serveurs simples rapidement (de nombreuses équipes commencent avec un serveur « analytique en lecture seule », puis ajoutent des actions d'écriture). Des exemples communautaires et des modèles existent pour les backends et les langages courants. Pour la rapidité, vous pouvez aussi adopter des serveurs maintenus par des fournisseurs (GitHub, CI/CD, communications).

Déploiement pragmatique en 6 étapes pour les plateformes SaaS

Choisissez un flux à forte valeur et faible risque. Par ex., « Créer/lire des incidents » ou « Lire des tableaux de bord ». Gardez le périmètre réduit pour des victoires de la première semaine.

Installez un serveur PCM pour ce flux avec des identifiants de moindre privilège ; exposez un petit ensemble d'outils bien typés et validez les arguments.

Intégrez un hôte (Claude Desktop ou OpenAI Agents) dans un tenant de développement. Intégrer les secrets via votre coffre-fort standard et les gérer.

Ajoutez des garde-fous : validation de schéma, listes d'autorisation, vérifications de sortie, enregistrement d'audit. Mappez chaque outil à une politique nommée.

Pilotez avec des utilisateurs réels dans Slack ou VS Code. Suivez l'exactitude, les taux d'échec d'action, et le temps de résolution par rapport à votre base de référence.

Renforcez et échelle : introduisez le mTLS, des périmètres par outil, et des modèles de chiffrement pour les données réglementées ; ajoutez ensuite plus de serveurs à votre catalogue.

Cas d'utilisation typiques que nous voyons

Support client & opérations : Créez des tickets, résumez des cas, et interrogez le CRM avec des appels d'outils auditables.

Productivité des développeurs : Gérez des dépôts/CI depuis chat ; recherche de code avec accès contrôlé en écriture.

Accès aux données : Requêtes en langage naturel contre des entrepôts via des serveurs en lecture seule, avec une politique de niveau ligne.

Automatisation gouvernée : Orchestrer des flux de travail à étapes multiples entre les applications SaaS tout en gardant une seule trace d'audit.

Comment le PCM se compare aux intégrations d'outils sur mesure

Dimension | Approche PCM | Outils point-à-point |

|---|---|---|

Vitesse d'intégration | Schéma standard ; réutiliser sur les hôtes | Reconstruction par modèle/fournisseur |

Gouvernance | Politique à la frontière du serveur | Dispersée entre bots/applications |

Portabilité | Fonctionne à travers les hôtes conformes | Verrouillé au fournisseur |

Sécurité | Centraliser l'authentification, l'audit, les périmètres | Souvent dupliqué/incohérent |

(Points saillants dérivés du spécification et des documents de plateforme.) Protocole de Contexte Modèle

Le chemin à suivre

Avec le soutien de Microsoft et d'autres pour l'interopérabilité, et OpenAI/Anthropic offrant le support client, le PCM semble prêt à sous-tendre un « web agentif » où les outils conformes interagissent comme les services web après HTTP 1.1. Attendez-vous à des schémas plus solides, à des découvertes plus riches, et à des extensions d'entreprise (gouvernance, limites de taux, et identité).

Appel à l'action : Si vous prévoyez des fonctionnalités IA dans votre produit, le moment est venu de prototyper sur PCM pour pouvoir changer d'hôte plus tard sans re-platformer.

FAQ sur le Protocole de Contenu Modèle (PCM)

Q1 : Le PCM est-il propriétaire d'Anthropic ?

Non. Anthropic l'a initié, mais le PCM est un standard ouvert avec une spécification publique et un support multivendeur.

Q2 : OpenAI supporte-t-il PCM ?

Oui—via des connecteurs/serveurs PCM distants dans l'API/SDK d'agents et un support précoce dans le mode développeur de ChatGPT.

Q3 : Quels risques les équipes de sécurité devraient-elles surveiller ?

Injection de demande, permissions mal définies, et fuites de données ; associez le PCM à une authentification stricte, à une politique, et à un audit.

Q4 : Comment commencer ?

Commencez par un serveur de référence et le SDK, connectez un outil simple (par ex., une recherche ou une interrogation de base de données), puis connectez via un client supporté tel que ChatGPT. Ajoutez l'enregistrement et l'authentification tôt, et itérez vers de vrais flux de travail en validant la valeur et le risque.

Q5 : Qu'est-ce que le Protocole de Contexte Modèle (PCM) ?

R : Le PCM est un standard ouvert permettant aux applications IA de se connecter en toute sécurité à des données externes, des outils, et des flux de travail—afin que les modèles puissent récupérer le bon contexte et appeler le bon outil sans intégrations sur mesure.

Q6 : Comment le PCM fonctionne-t-il en pratique ?

R : Le PCM utilise un modèle client-serveur. Un serveur PCM expose des outils ou des données ; un client PCM-connecté se connecte à ce serveur et permet au modèle de lister et appeler ces outils lors d'une conversation.

Q7 : ChatGPT supporte-t-il PCM ?

R : Oui. ChatGPT (et les APIs compatibles) peuvent se connecter à des serveurs PCM distants pour que les modèles puissent découvrir et appeler les outils du serveur directement—par exemple, pour rechercher dans les bases de connaissances, interroger des bases de données ou déclencher des flux de travail.

Q8 : Quels sont les cas d'utilisation courants du PCM ?

R : Recherche et récupération d'entreprise, requêtes analytiques, opérations de code/dépôt, ticketing et automatisations informatiques, gestion de la connaissance, et flux de travail d'agents multi-outils.

Q9 : Comment le PCM est-il différent des plugins ou des APIs uniques ?

R : Les plugins ou APIs directs sont sur mesure par app. Le PCM standardise l'interface de sorte que tout client PCM-connecté peut se connecter à tout serveur PCM, réduisant les frais d'intégration et rendant les outils portables entre les modèles et hôtes.

Q10 : Comment connecter un serveur PCM distant à mon application IA ?

R : Pointez votre client PCM-connecté ou SDK vers le point de terminaison du serveur (ou exécutez-le localement), fournissez les identifiants, et permettez au modèle d'énumérer les outils. Le modèle peut alors appeler les outils avec des paramètres et recevoir des sorties structurées.

Q11 : Qu'en est-il de la sécurité et de la gouvernance avec le PCM ?

R : Traitez les serveurs PCM comme des intégrations de production : utilisez une authentification forte, un accès de moindre privilège, et la rotation des secrets ; enregistrez les appels d'outils ; défendez contre l'injection de demande. Gardez les serveurs sensibles privés et appliquez la prévention des pertes de données.

Q12 : Le PCM est-il ouvert et neutre en termes de fournisseurs ?

R : Oui. Le PCM est une spécification ouverte, neutre en termes de fournisseurs, avec des implémentations communautaires et des serveurs exemples, conçue pour l'interopérabilité entre modèles et plateformes.

Protocole de Contexte Modèle (PCM) : Ce que c'est et comment l'adopter

Si votre feuille de route inclut des assistants IA qui agissent sur des systèmes réels, en créant des tickets, en publiant sur Slack, en interrogeant Snowflake, le PCM est la manière la plus rapide et la moins risquée pour mettre cela en place. Né à la fin de 2024 et renforcé tout au long de 2025, le PCM standardise la manière dont les applications de LLM se connectent aux outils et aux données, vous évitant ainsi de reconstruire les intégrations pour chaque modèle ou fournisseur.

Définition en 60 secondes

Le PCM est un protocole ouvert pour connecter les applications IA (le “hôte”) à des capacités externes via un modèle client-serveur. L'hôte intègre un client PCM ; vos outils/données résident derrière un ou plusieurs serveurs PCM. Le client parle un protocole bien spécifié (JSON-RPC 2.0) permettant au LLM de découvrir des outils, appeler des fonctions, et récupérer un contexte de manière cohérente.

Pensez au PCM comme à l'USB-C pour l'IA, un port qui fonctionne avec de nombreux périphériques. Remplacez Claude par ChatGPT ou vice-versa sans réécrire chaque connecteur.

Pourquoi le PCM est important pour les équipes SaaS en 2025

Réduit le problème N×M. Au lieu de construire N intégrations sur mesure pour M modèles, le PCM abstrait l'interface de sorte qu'un serveur peut fonctionner avec plusieurs hôtes LLM. Cela réduit la complexité et le délai de mise sur le marché.

Momentum écosystémique large. Le PCM a commencé avec Anthropic et apparaît maintenant dans les environnements de développement intégrés (IDE), Claude Desktop, et les connecteurs/SDK d'agents d'OpenAI—avec un support précoce dans le mode développeur de ChatGPT. Cette énergie inter-fournisseurs est pourquoi de nombreux CIO considèrent le PCM comme le chemin par défaut vers le SaaS « prêt pour les agents ».

Des modèles de qualité entreprise émergent. Les fournisseurs publient des couches de sécurité « défendre pour PCM » et des modèles centrés sur le chiffrement alignés sur les secteurs réglementés, accélérant l'adoption sécurisée.

Architecture de base (modèle mental simple)

Hôte : L'application IA (par exemple, Claude Desktop, ChatGPT) exécutant un client PCM.

Client PCM : Traduit l'intention de l'utilisateur/appels outil en messages de protocole.

Serveur(s) PCM : Votre côté — APIs, bases de données, ou flux de travail exposés avec des définitions d'outils basées sur un schéma et des réponses via JSON-RPC 2.0.

Cette séparation permet aux équipes de la plateforme de publier un catalogue de capacités sécurisées (par exemple, « créer un problème Jira », « interroger BigQuery ») que tout LLM conforme peut utiliser—sous réserve de politique et d'autorisation.

Quelles plateformes supportent actuellement le PCM ?

Anthropic Claude / Claude Desktop : Référence PCM de première partie avec de nombreux exemples de serveurs. anthropic.com

OpenAI : Connecteurs et serveurs PCM distants via l'API/SDK d'agents d'OpenAI ; un support client plus large est en émergence dans le mode développeur. OpenAI Platform

Outils développeur : Serveurs officiels et communautaires pour GitHub, Buildkite et plus ; des listes open-source florissantes pour accélérer l'intégration. GitHub

Intérêt industriel : Microsoft a publiquement soutenu les standards industriels comme le PCM pour aider les écosystèmes d'agents à interagir.

Notre écosystème partenaire (prêt pour le PCM)

Asana — Serveur PCM officiel permet aux outils IA de créer/lire des tâches et d'interagir avec le Work Graph via des outils standards. (Asana)

Miro — Serveur PCM disponible (actuellement étiqueté bêta/liste d'attente dans certains matériaux) pour interroger le contexte du tableau et déclencher des actions à partir des outils IA. (developers.miro.com)

Notion — Le Notion PCM hébergé permet une lecture/écriture sécurisée des objets de l'espace de travail ; fonctionne avec Claude, ChatGPT et Cursor. (developers.notion.com)

Glean — Serveur PCM distant intégré à la plateforme pour exposer la connaissance d'entreprise sensible aux permissions à tout hôte compatible PCM. (developers.glean.com)

Partenaire | Statut PCM | Docs |

|---|---|---|

Asana | GA : serveur PCM officiel | Documents « Serveur PCM » et guide d'intégration. Asana |

Miro | Bêta / liste d'attente notée dans le site | Guides développeur + page publique de liste d'attente. developers.miro.com |

Notion | GA : PCM hébergé | Documents développeur + aperçu du centre d'aide. developers.notion.com |

Glean | GA : serveur PCM distant | Guides administrateur et utilisateur. developers.glean.com |

Sécurité : ce que le PCM résout—et ce qu'il ne résout pas

Le PCM n'est pas une solution miracle. Il vous offre un conduit cohérent ; vous avez toujours besoin de garde-fous d'entreprise :

Menaces : Injection de demande, serveurs surprivileges, et sorties non fiables peuvent entraîner des fuites de données ou des actions involontaires (par ex., « PCM-MAJ »).

Contrôles à ajouter :

Forte authentification/autorisation à la frontière du serveur (tokens, mTLS, RBAC limité).

Filtres de politique pour restreindre les arguments et les sorties des outils.

Audit/enregistrement de chaque appel et réponse d'outil.

Modèles de sécurité des données (chiffrement au niveau de l'application / gardez vos propres clés) pour les stocks sensibles.

Construire vs acheter : serveurs PCM

Vous pouvez construire des serveurs simples rapidement (de nombreuses équipes commencent avec un serveur « analytique en lecture seule », puis ajoutent des actions d'écriture). Des exemples communautaires et des modèles existent pour les backends et les langages courants. Pour la rapidité, vous pouvez aussi adopter des serveurs maintenus par des fournisseurs (GitHub, CI/CD, communications).

Déploiement pragmatique en 6 étapes pour les plateformes SaaS

Choisissez un flux à forte valeur et faible risque. Par ex., « Créer/lire des incidents » ou « Lire des tableaux de bord ». Gardez le périmètre réduit pour des victoires de la première semaine.

Installez un serveur PCM pour ce flux avec des identifiants de moindre privilège ; exposez un petit ensemble d'outils bien typés et validez les arguments.

Intégrez un hôte (Claude Desktop ou OpenAI Agents) dans un tenant de développement. Intégrer les secrets via votre coffre-fort standard et les gérer.

Ajoutez des garde-fous : validation de schéma, listes d'autorisation, vérifications de sortie, enregistrement d'audit. Mappez chaque outil à une politique nommée.

Pilotez avec des utilisateurs réels dans Slack ou VS Code. Suivez l'exactitude, les taux d'échec d'action, et le temps de résolution par rapport à votre base de référence.

Renforcez et échelle : introduisez le mTLS, des périmètres par outil, et des modèles de chiffrement pour les données réglementées ; ajoutez ensuite plus de serveurs à votre catalogue.

Cas d'utilisation typiques que nous voyons

Support client & opérations : Créez des tickets, résumez des cas, et interrogez le CRM avec des appels d'outils auditables.

Productivité des développeurs : Gérez des dépôts/CI depuis chat ; recherche de code avec accès contrôlé en écriture.

Accès aux données : Requêtes en langage naturel contre des entrepôts via des serveurs en lecture seule, avec une politique de niveau ligne.

Automatisation gouvernée : Orchestrer des flux de travail à étapes multiples entre les applications SaaS tout en gardant une seule trace d'audit.

Comment le PCM se compare aux intégrations d'outils sur mesure

Dimension | Approche PCM | Outils point-à-point |

|---|---|---|

Vitesse d'intégration | Schéma standard ; réutiliser sur les hôtes | Reconstruction par modèle/fournisseur |

Gouvernance | Politique à la frontière du serveur | Dispersée entre bots/applications |

Portabilité | Fonctionne à travers les hôtes conformes | Verrouillé au fournisseur |

Sécurité | Centraliser l'authentification, l'audit, les périmètres | Souvent dupliqué/incohérent |

(Points saillants dérivés du spécification et des documents de plateforme.) Protocole de Contexte Modèle

Le chemin à suivre

Avec le soutien de Microsoft et d'autres pour l'interopérabilité, et OpenAI/Anthropic offrant le support client, le PCM semble prêt à sous-tendre un « web agentif » où les outils conformes interagissent comme les services web après HTTP 1.1. Attendez-vous à des schémas plus solides, à des découvertes plus riches, et à des extensions d'entreprise (gouvernance, limites de taux, et identité).

Appel à l'action : Si vous prévoyez des fonctionnalités IA dans votre produit, le moment est venu de prototyper sur PCM pour pouvoir changer d'hôte plus tard sans re-platformer.

FAQ sur le Protocole de Contenu Modèle (PCM)

Q1 : Le PCM est-il propriétaire d'Anthropic ?

Non. Anthropic l'a initié, mais le PCM est un standard ouvert avec une spécification publique et un support multivendeur.

Q2 : OpenAI supporte-t-il PCM ?

Oui—via des connecteurs/serveurs PCM distants dans l'API/SDK d'agents et un support précoce dans le mode développeur de ChatGPT.

Q3 : Quels risques les équipes de sécurité devraient-elles surveiller ?

Injection de demande, permissions mal définies, et fuites de données ; associez le PCM à une authentification stricte, à une politique, et à un audit.

Q4 : Comment commencer ?

Commencez par un serveur de référence et le SDK, connectez un outil simple (par ex., une recherche ou une interrogation de base de données), puis connectez via un client supporté tel que ChatGPT. Ajoutez l'enregistrement et l'authentification tôt, et itérez vers de vrais flux de travail en validant la valeur et le risque.

Q5 : Qu'est-ce que le Protocole de Contexte Modèle (PCM) ?

R : Le PCM est un standard ouvert permettant aux applications IA de se connecter en toute sécurité à des données externes, des outils, et des flux de travail—afin que les modèles puissent récupérer le bon contexte et appeler le bon outil sans intégrations sur mesure.

Q6 : Comment le PCM fonctionne-t-il en pratique ?

R : Le PCM utilise un modèle client-serveur. Un serveur PCM expose des outils ou des données ; un client PCM-connecté se connecte à ce serveur et permet au modèle de lister et appeler ces outils lors d'une conversation.

Q7 : ChatGPT supporte-t-il PCM ?

R : Oui. ChatGPT (et les APIs compatibles) peuvent se connecter à des serveurs PCM distants pour que les modèles puissent découvrir et appeler les outils du serveur directement—par exemple, pour rechercher dans les bases de connaissances, interroger des bases de données ou déclencher des flux de travail.

Q8 : Quels sont les cas d'utilisation courants du PCM ?

R : Recherche et récupération d'entreprise, requêtes analytiques, opérations de code/dépôt, ticketing et automatisations informatiques, gestion de la connaissance, et flux de travail d'agents multi-outils.

Q9 : Comment le PCM est-il différent des plugins ou des APIs uniques ?

R : Les plugins ou APIs directs sont sur mesure par app. Le PCM standardise l'interface de sorte que tout client PCM-connecté peut se connecter à tout serveur PCM, réduisant les frais d'intégration et rendant les outils portables entre les modèles et hôtes.

Q10 : Comment connecter un serveur PCM distant à mon application IA ?

R : Pointez votre client PCM-connecté ou SDK vers le point de terminaison du serveur (ou exécutez-le localement), fournissez les identifiants, et permettez au modèle d'énumérer les outils. Le modèle peut alors appeler les outils avec des paramètres et recevoir des sorties structurées.

Q11 : Qu'en est-il de la sécurité et de la gouvernance avec le PCM ?

R : Traitez les serveurs PCM comme des intégrations de production : utilisez une authentification forte, un accès de moindre privilège, et la rotation des secrets ; enregistrez les appels d'outils ; défendez contre l'injection de demande. Gardez les serveurs sensibles privés et appliquez la prévention des pertes de données.

Q12 : Le PCM est-il ouvert et neutre en termes de fournisseurs ?

R : Oui. Le PCM est une spécification ouverte, neutre en termes de fournisseurs, avec des implémentations communautaires et des serveurs exemples, conçue pour l'interopérabilité entre modèles et plateformes.

Recevez chaque semaine des nouvelles et des conseils sur l'IA directement dans votre boîte de réception

En vous abonnant, vous consentez à ce que Génération Numérique stocke et traite vos informations conformément à notre politique de confidentialité. Vous pouvez lire la politique complète sur gend.co/privacy.

Ateliers et webinaires à venir

Clarté opérationnelle à grande échelle - Asana

Webinaire Virtuel

Mercredi 25 février 2026

En ligne

Collaborez avec des coéquipiers IA - Asana

Atelier en personne

Jeudi 26 février 2026

London, UK

De l'idée au prototype - L'IA dans Miro

Webinaire virtuel

Mercredi 18 février 2026

En ligne

Génération

Numérique

Bureau du Royaume-Uni

Génération Numérique Ltée

33 rue Queen,

Londres

EC4R 1AP

Royaume-Uni

Bureau au Canada

Génération Numérique Amériques Inc

181 rue Bay, Suite 1800

Toronto, ON, M5J 2T9

Canada

Bureau aux États-Unis

Generation Digital Americas Inc

77 Sands St,

Brooklyn, NY 11201,

États-Unis

Bureau de l'UE

Génération de logiciels numériques

Bâtiment Elgee

Dundalk

A91 X2R3

Irlande

Bureau du Moyen-Orient

6994 Alsharq 3890,

An Narjis,

Riyad 13343,

Arabie Saoudite

Numéro d'entreprise : 256 9431 77 | Droits d'auteur 2026 | Conditions générales | Politique de confidentialité

Génération

Numérique

Bureau du Royaume-Uni

Génération Numérique Ltée

33 rue Queen,

Londres

EC4R 1AP

Royaume-Uni

Bureau au Canada

Génération Numérique Amériques Inc

181 rue Bay, Suite 1800

Toronto, ON, M5J 2T9

Canada

Bureau aux États-Unis

Generation Digital Americas Inc

77 Sands St,

Brooklyn, NY 11201,

États-Unis

Bureau de l'UE

Génération de logiciels numériques

Bâtiment Elgee

Dundalk

A91 X2R3

Irlande

Bureau du Moyen-Orient

6994 Alsharq 3890,

An Narjis,

Riyad 13343,

Arabie Saoudite

Numéro d'entreprise : 256 9431 77

Conditions générales

Politique de confidentialité

Droit d'auteur 2026